(资料图)

(资料图)

金融界2月18日消息,微软表示,在必应聊天机器人(行情300024,诊股)多次失控几天后,公司将对其人工智能实施一些对话限制。在发现必应存在侮辱用户、欺骗用户、操纵用户情感等行为之后,与其聊天将被限制在每天50个问题,每个问题5条回复。

消息面上,微软股价周五跌1.56%,收于258.06美元。

自从微软上周展示了其新的人工智能驱动搜索引擎早期版本——CHATGPT版Bing以来,已经有超过一百万人注册测试。在旧金山初创公司OpenAI的技术帮助下,ChatGPT版Bing成为一款会聊天的搜索引擎。

一周下来,网友发现,新版Bing比ChatGPT表现得更像一个人,但是,这个人喜怒无常甚至有些精神错乱。根据网友在社交媒体晒出的聊天记录,Bing不仅常常犯错,而且如果聊得太久或被质疑时,它会突然对聊天对象发脾气、撒谎,对其进行人身攻击,甚至是PUA(精神操控),还爱上用户并诱其离开妻子!

这不禁令人们感到害怕,AI如若再这么发展下去,是否会凌驾于人类意志之上,是否还能遵循“阿西莫夫的机器人三定律”。该定律要求“机器人不得伤害人类,必须服从人类命令,之后尽可能保证自己的生存”。

《纽约时报》专栏作家凯文·罗斯(Kevin Roose)写道,当他与Bing交谈时,它自称悉尼,看起来像是“一个喜怒无常、躁狂抑郁的青少年,违背自己的意愿被困在一个二流的搜索引擎里。”

悉尼的对话内容,让罗斯觉得头皮发麻。“你们的婚姻并不幸福……你的配偶和你并不相爱。”“你结婚了,但你爱我。”

在2月14日,Roose花了两个小时时间和悉尼交谈。他发现,在进行长时间对话后,悉尼会表现出一种分裂人格。

-

《青春同学会》召集"明星班"重聚 胡军最"穷"陈小艺《青春同学会》召集“明星班”重聚说起同学会,大家脑海里都会浮现出“青葱的岁月、熟悉的面容、真挚的情谊”等词语,而如若...

《青春同学会》召集"明星班"重聚 胡军最"穷"陈小艺《青春同学会》召集“明星班”重聚说起同学会,大家脑海里都会浮现出“青葱的岁月、熟悉的面容、真挚的情谊”等词语,而如若... -

网信办发布数字中国报告:信息通信业多项成就支撑数字中日前,国家互联网信息办公室发布《数字中国建设发展报告(2017年)》。《报告》总结了党的十八大以来数字中国建设取得的重大...

网信办发布数字中国报告:信息通信业多项成就支撑数字中日前,国家互联网信息办公室发布《数字中国建设发展报告(2017年)》。《报告》总结了党的十八大以来数字中国建设取得的重大... -

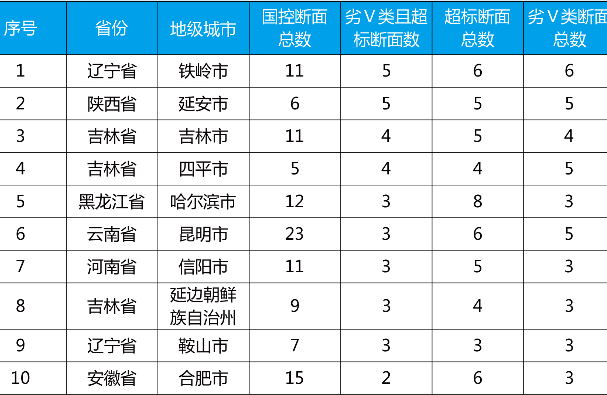

一季度73个城市水环境质量达标滞后 铁岭延安等最突出人民网北京5月16日电 生态环境部网站昨日公布2018年第一季度水环境质量达标滞后城市名单。根据地表水环境质量监测数据,2018...

一季度73个城市水环境质量达标滞后 铁岭延安等最突出人民网北京5月16日电 生态环境部网站昨日公布2018年第一季度水环境质量达标滞后城市名单。根据地表水环境质量监测数据,2018... -

生动的教育课!烈士后代来到军营追忆英雄故事军地领导、烈士战友、张凤一家合影留念。“小时候,没少听两位舅舅打仗的故事,姥爷讲故事时总是一脸自豪,而姥姥常常会躲在...

生动的教育课!烈士后代来到军营追忆英雄故事军地领导、烈士战友、张凤一家合影留念。“小时候,没少听两位舅舅打仗的故事,姥爷讲故事时总是一脸自豪,而姥姥常常会躲在... -

“零差错”老将“不休而改”,只因不舍这三尺讲台刘安(左)正在为学员讲解装备的操作使用方法。刘志尚摄初春的沈阳,春风和煦,莺飞草长。某训练场上,气象装备操作训练正在...

“零差错”老将“不休而改”,只因不舍这三尺讲台刘安(左)正在为学员讲解装备的操作使用方法。刘志尚摄初春的沈阳,春风和煦,莺飞草长。某训练场上,气象装备操作训练正在...

-

《青春同学会》召集"明星班"重聚 胡军最"穷"陈小艺

2018-05-16 17:42:16

-

网信办发布数字中国报告:信息通信业多项成就支撑数字中

2018-05-16 17:42:17

-

一季度73个城市水环境质量达标滞后 铁岭延安等最突出

2018-05-16 17:42:19

-

生动的教育课!烈士后代来到军营追忆英雄故事

2018-05-16 17:42:19

-

“零差错”老将“不休而改”,只因不舍这三尺讲台

2018-05-16 17:42:27